1. Definition

Textdigitalisierung bezeichnet den Prozess der Umwandlung eines gedruckten oder handschriftlichen Textes in einen maschinell lesbaren elektronischen Text. Je nach Beschaffenheit des Ausgangstextes kommen in diesem Prozess der Texterfassung bzw. Transkription mehrere potentielle Bearbeitungsschritte in Frage – automatisierte (optical character recognition (OCR): optische Zeichenerkennung) wie manuelle (keying).

2. Anwendungsbeispiel

Angenommen, Sie wollen das Prosaoeuvre von Ingeborg Bachmann erforschen und sich dabei digital unterstützen lassen. Das Problem ist, dass Bachmanns Texte nicht gemeinfrei und damit nicht als fertige Textdigitalisate zugänglich sind. Sie haben nun die Möglichkeit, die gedruckten Texte selbst in digital lesbare Textdateien umzuwandeln, um anschließend die Methoden und Tools der digitalen Textanalyse nutzen zu können. Zu welchen Problemen es bei einer automatisierten Texterfassung kommen kann, wird anhand eines Ausschnittes aus Bachmanns Erzählung Das Gebell (1972) unter Punkt 5 dieses Beitrags veranschaulicht. Texte, die urheberrechtlich geschützt sind, dürfen jedoch nur für den privaten bzw. eigenen wissenschaftlichen Gebrauch digitalisiert und nicht veröffentlicht oder vervielfältigt werden.

3. Literaturwissenschaftliche Tradition

Die Digitalisierung von Texten führt mehrere Traditionslinien fort: (1) die Editionsphilologie und Textkritik, (2) die Paläografie und auch (3) das Setzen von Manuskripten seit der Erfindung des Buchdrucks.

1) Mit der Erfindung der Schrift vor über 5000 Jahren wurde eine Möglichkeit geschaffen, die auch als Leitbild der Textdigitalisierung verstanden werden kann: „die konsistente Bewahrung der sprachlichen Äußerung durch sie repräsentierende Zeichen“ (Nutt-Kofoth 2007, 1). Möchte man einen Text elektronisch lesbar machen, sollten einige Maximen der Editionswissenschaft, die sich mit dieser konsistenten Bewahrung beschäftigt, beachtet werden. Dies gilt insbesondere für Texte, die selbst aus historisch-kritischen Ausgaben stammen, denn hier ist eine korrekte Texterfassung die Basis für jede wissenschaftlich tragbare Weiterverarbeitung und auch in der elektronischen Version sollten einzelne Elemente der Edition (wie Stemma, Apparat, Kommentar und Register; vgl. Sproll 2007, 178) differenziert werden können. Historisch-kritische Ausgaben, kritische Ausgaben, Studienausgaben oder Leseausgaben stellen in der Editionswissenschaft unterschiedliche Ansprüche an die Authentizität der Textwiedergabe. In vielen Ausgaben der einzelnen Editionsvarianten (außer der (historisch-)kritischen) greifen die jeweiligen Herausgeber normalisierend in Orthografie und Interpunktion ein (vgl. Nutt-Kofoth 2007, 6f.). Was in der Editionsphilologie ein „diplomatischer Abdruck“ (Grubmüller und Weimar 1997, 414) genannt wird, sollte jedoch auch das Ziel der digitalen Erfassung eines gedruckten Textes sein: die „urkundlich genaue, zeichengetreue Wiedergabe eines Textes, d. h. unter Bewahrung aller Besonderheiten und auch Uneinheitlichkeiten von Orthografie und Interpunktion“ (ebd.).

Historische Orthografie korrekt abzubilden, ist für die automatische Texterkennung (OCR), die ihre Ergebnisse auf Grundlage aktueller Rechtschreibung korrigiert, eine Herausforderung, jedoch ein wichtiger Orientierungspunkt, denn sie „ist nichts Äußerliches, Akzidentelles, sondern als ein Teil der historischen Form bedeutungskonstituierendes Merkmal“ (Kraft 2001, 72). Auch die Wahrung des Lautstandes ist hierbei ein wichtiger Grund der originalgetreuen Wiedergabe (vgl. Kraft 2001, 85). Der Umgang mit dem Original statt einem Faksimile ist eine Maxime der textkritischen Arbeit, denn „[b]ereits durch eine Verkleinerung oder eine Vergrößerung des Originals tritt ein ‘Informationsverlust’ ein“ (Kraft 2001, 63). Der im ersten Schritt der Textdigitalisierung erstellte Scan (s. u.) muss demnach dem Original so ähnlich wie möglich sehen, um einen solchen Informationsverlust zu vermeiden.

Die Prinzipien der Textkritik, die sich im engeren Sinne mit der Herstellung eines Archetypus anhand überlieferter Textzeugen eines verlorengegangenen Textes beschäftigt, in den neueren Philologien jedoch in der Editionstechnik aufgeht, finden im übertragenen Sinne ebenfalls eine Fortführung in der Textdigitalisierung. Recensio (mustern), examinatio (prüfen) und emendatio (verbessern) (vgl. Kocher 2007, 761) sind auf den Prozess der Vergleichsarbeit von gedrucktem und digitalisiertem Text übertragbar, wobei hier freilich der gedruckte Text als das Original vorliegt und nicht erschlossen werden muss. Dennoch müssen beispielsweise auch hier „Druck- und Schreibfehler sowie Schäden des Textträgers“ (Kocher 2007, 762) als solche identifiziert und ein Umgang mit ihnen gefunden werden.

2) Auch die Digitalisierung von Handschriften geht zurück auf eine literaturwissenschaftliche Tradition im weiteren Sinne bzw. eine ihrer Hilfswissenschaften, nämlich die Paläografie, in der es „ganz allgemein um das Lesenkönnen der alten Schriften […] aber auch die Physiologie und Psychologie des Schreibens“ (Rohr 2015, 125) geht (vgl. Schneider 2003, 1). Wesentliche Kategorien sind hier u. a. die Differenzierung unterschiedlicher Schreib- und Beschreibstoffe sowie die Identifikation von Abkürzungen und Sonderzeichen, des Duktus, Ligaturen, des Schriftwinkels oder der jeweils gebrauchten Schriftart (z. B. Druck- oder Schreibschrift, vereinfachte Ausgangsschrift, Majuskel- oder Minuskelschrift etc.), denn „verschiedene Schriftarten entstehen für unterschiedliche Zwecke, lassen sich in ihren Entwicklungsphasen und Blütezeiten nachvollziehen und werden schließlich von neuen Erscheinungen unterlaufen und letztlich abgelöst“ (Schneider 2014, 13).

3) Schließlich finden sich auch Veränderungen, die im Zuge des Buchdrucks die Umwandlung von Manuskripten in einen Drucksatz betrafen, in der heutigen Textdigitalisierung wieder. Beim Setzen geht es darum, das Manuskript buchstabengetreu wiederzugeben und häufig wurde dies durch einen Setzer und nicht den Autor selbst ausgeführt. „Eine der großen editorischen Schwierigkeiten bezüglich der Literatur der Frühen Neuzeit, der ersten Jahrhunderte nach Gutenberg bis zum Barock, besteht in der Klärung der Frage, […] wie sich der Text durch vielfache Wiederabdrucke verschlechtert hat“ (Nutt-Kofoth 2007, 11). Diese Frage sollte auch an ein Textdigitalisat gestellt werden.

4. Diskussion

Die automatische Texterfassung mittels sogenannter Optical Character Recognition (OCR) eignet sich besonders für sauber gedruckte Texte mit einer gewöhnlichen Schriftart und ohne manuell hinzugefügte Annotationen. Je mehr ein Text von diesem Ideal der Erfassbarkeit abweicht, desto schwieriger wird es, mittels automatisierter Verfahren ein annehmbares Ergebnis als Digitalisat zu erhalten. Die Tradition der optischen Zeichenerkennung reicht überraschend weit zurück. Der bereits in der Antike lebendige Traum, menschliche Fähigkeiten durch Maschinen nachzubilden, findet mit der Erfindung eines Retinascanners durch C. R. Carey 1870 in Massachusetts eine vorläufige Erfüllung (vgl. Eikvil 1993, 8).

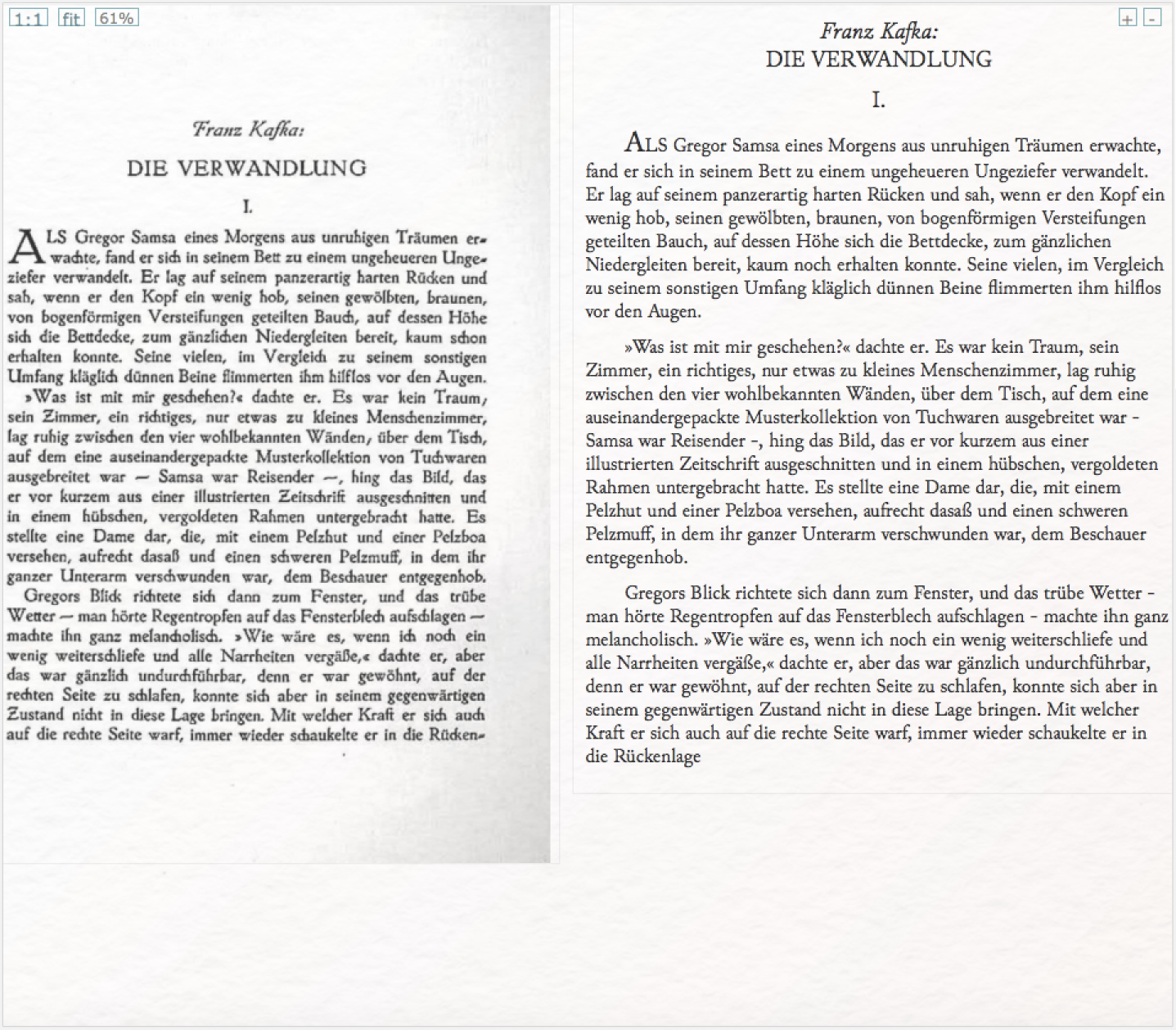

Die Muster in heutigen OCR-Datenbanken, mit denen die erfassten Buchstaben abgeglichen werden, sind schriftartenspezifisch, weshalb auch die Wahl des OCR-Programms entscheidend zum Erfolg der Textdigitalisierung beiträgt. Die gängigsten Druckschriftarten sind in alle OCR-Softwares implementiert, moderne Anwendungen können zudem auf weitere Schriftarten „trainiert“ werden. Formatierungen wie eine Kursivierung oder Unterstreichung von Buchstaben oder Wörtern, unterschiedliche Schriftarten innerhalb eines Dokumentes und auch ein uneinheitlicher Buchstabenabstand (z. B. in Texten, die mit einer Schreibmaschine geschrieben wurden) können hier zu Schwierigkeiten führen. Ebenso können komplexere Layouts – z. B. ein Text mit mehreren Spalten oder Abbildungen – für die automatische Texterfassung große Herausforderungen bilden.

Fortgeschrittenere Programme gleichen die Ergebnisse in einem weiteren Schritt mit Wörterbucheinträgen ab und passen sie diesen bei Bedarf an. Problematisch sind hier historische Texte (die ein historisches Wörterbuch voraussetzen), uneinheitliche Schreibungen von Wörtern oder die Häufung von Eigennamen, die in der Regel nicht in einem Wörterbuch aufgeführt werden, jedoch häufig gerade in fiktionalen Texten vorkommen. Auch mehrsprachige Texte führen hier zu Schwierigkeiten. Auf Frakturschrift sind nur verhältnismäßig wenig Programme spezialisiert, am häufigsten wird hier der → ABBYY FineReader genannt, der jedoch nicht kostenfrei zu nutzen ist.

Die Angabe von Fehlerquoten bei der Evaluierung einzelner OCR-Programme ist mit Vorsicht zu genießen, da sie sich manchmal auf die Menge korrekt erfasster Wörter, manchmal aber auch auf die Menge korrekt erkannter Buchstaben in einem Textdokument bezieht. Zudem bleibt dabei der Effekt, den das jeweilige Preprocessing auf die Fehlerquote hat, im Dunkeln. Schließlich ist das Überprüfen von Fehlern in automatisch erfassten Texten sehr aufwändig und wird nur selten umfassend betrieben: eine Gegebenheit, die zu nicht repräsentativen Quoten führt. Das DFG-Projekt OCR-D widmet sich diesen Missständen und arbeitet außerdem daran, bestehende Verfahren zur automatischen Texterfassung in Hinblick auf die Besonderheiten von deutschsprachigen Texten des 16.–19. Jahrhunderts zu optimieren.

Komplizierter als die automatische Erkennung von gedruckter Schrift ist der Bereich der automatischen Handschriftenerkennung (→ Digitale Manuskriptanalyse). Handgeschriebene Schrift folgt sehr individuellen Mustern und variiert nicht nur zwischen unterschiedlichen Autor*innen stark, sondern häufig auch innerhalb des Werkes oder gar einzelner Texte von individuellen Autor*innen. Das → Transkribus-Projekt bietet im Umgang mit Handschriften und ihrer Digitalisierung eine verlässliche Anlaufstelle.

Wegen der genannten Schwierigkeiten greift man in der Regel gerade bei Handschriften auf die Methode des keying (d. h. dem manuellen Abtippen des Textes) zurück, um eine wissenschaftlich verwertbare Genauigkeit des digitalisierten Textes zu erreichen. Exemplarische Untersuchungen der Textsammlung des → Deutschen Textarchivs haben ergeben, dass die Erfassungsgenauigkeit sehr viel höher ist, wenn statt einer automatisierten optischen Zeichenerkennung das manuelle Verfahren des Double Keyings eingesetzt wird (vgl. Geyken et al. 2012, 9). Beim Keying tippt lediglich eine Person den zu digitalisierenden Text händisch ab, wodurch es zu Lese- oder Flüchigkeitsfehlern kommen oder schlecht lesbarer Text falsch interpretiert werden kann. Im Double Keying-Verfahren hingegen erfassen zwei Personen den Text jeweils einmal manuell. Daraufhin werden Uneinheitlichkeiten in den beiden getrennt voneinander entstandenen Digitalisaten automatisch erfasst und von einer dritten Person händisch überprüft und ggf. korrigiert. Das Double Keying wird häufig an externe Anbieter ausgelagert, erfordert größere finanzielle Mittel als das OCR-Verfahren, überzeugt jedoch durch seine sehr hohe Genauigkeit (99.95% bis 99.98%). Auch bei diesen Quoten ist jedoch darauf zu achten, dass die Tests häufig nur beispielhaft anhand verhältnismäßig kleiner Textausschnitte durchgeführt wurden und es oft keine genaueren Angaben über die tatsächliche Textmenge, das Textgenre, die Art der gefundenen Fehler oder über die Transkriptoren gibt (vgl. Haaf, Wiegand und Geyken 2013).

5. Technische Grundlagen

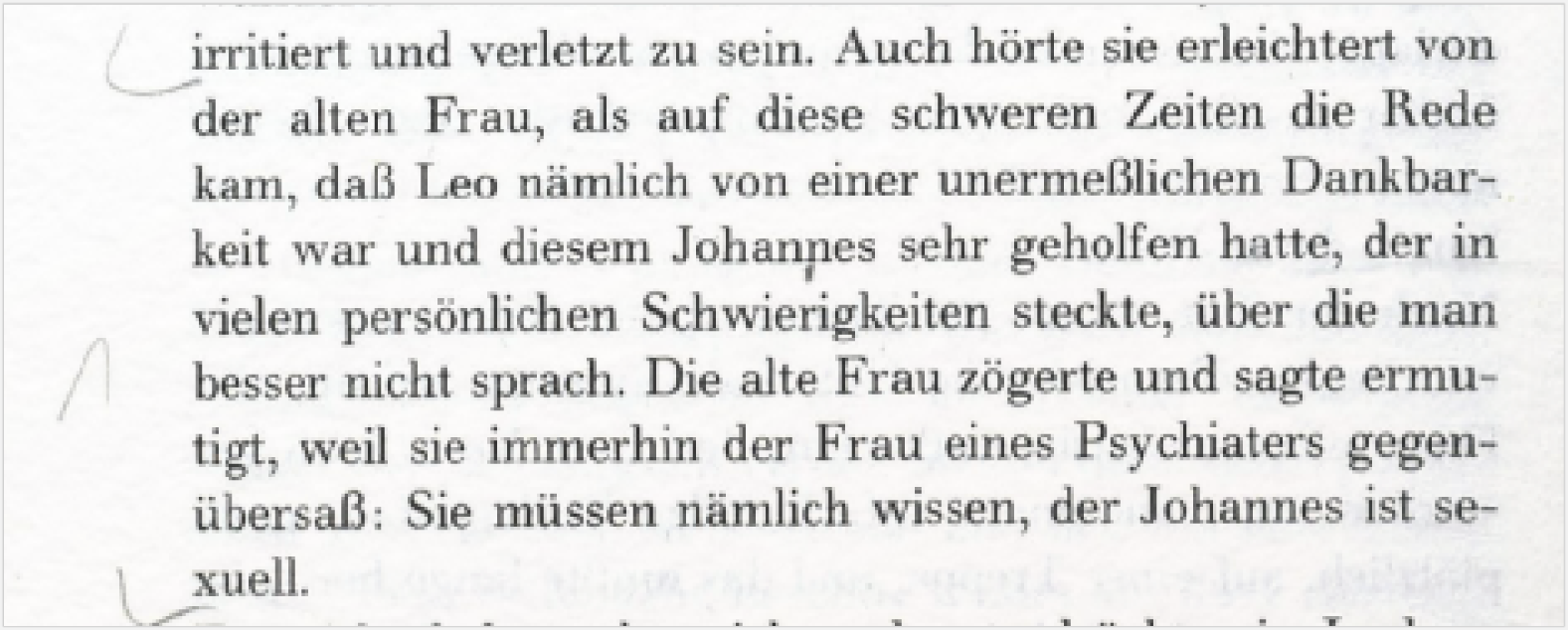

Wenn Sie die Texte, die Sie erforschen wollen, selbst einscannen, achten Sie auf eine hohe Bildauflösung. Programme zur automatisierten Texterfassung kommen schnell an ihre Grenzen, wenn die zugrundegelegten Scans mangelhaft sind. An der folgenden Abbildung (ein Ausschnitt aus Ingeborg Bachmanns Erzählung Das Gebell (1972)) kann dies demonstriert werden.

Die OCR-Funktion des Adobe Acrobat Pro erkennt darin folgenden Text:

LJrritiert und verletzt zu sein. Auch hörte sie erleichtert von

der alten Frau, als auf diese schweren Zeiten die Rede

kam, daß Leo nämlich von einer unermeßlichen Dankbar-.

keit war und diesem Johanpes sehr geholfen hatte, der in

vielen persönlichen Schwierigkeiten steckte, über die man

jl besser nicht sprach. Die alte Frau zögerte und sagte ermutigt,

weil sie immerhin der Frau eines Psychiaters gegenübersa.

: Sie müssen nämlich wissen, der Johannes ist seu

uell. . „ .

Wir sehen, dass das Programm offensichtlich Schwierigkeiten mit Schmutzflecken (z. B. „Johanpes“), Trennstrichen („seu uell“), gelegentlich dem Buchstaben ß („gegenübersa.:“ sowie manuellen Textannotationen („LJrritiert“) hat. Diese Fehler müssen nun entweder im Anschluss der automatischen Texterkennung manuell korrigiert werden, man beugt ihnen vor, indem man eine bessere Papier- und Scanqualität zugrunde legt, oder man findet ein OCR-Programm, das mit dem jeweiligen Text besser umgehen kann und besser verwertbare Ergebnisse liefert.

Eine OCR-Software identifiziert Abbildungen als solche und schließt sie aus der folgenden Texterkennung aus (Segmentierungsprozess). Ebenso werden Wortgrenzen, Zeilen und Absätze als solche festgestellt und Überschriften, Fußzeilen, Seitenzahlen etc. anhand ihres Abstandes zu den Blöcken des Haupttextes bzw. aufgrund divergierender Schriftarten gekennzeichnet. Jeder Punkt der Bilddatei wird entweder als Hintergrund oder als Text klassifiziert. In diesem Schritt der „Binarisierung“ (Rehbein 2017, 194) wurde der Fleck unter „Johannes“ als Text klassifiziert und führte daher zur fehlerhaften Texterkennung. Die als „Text“ identifizierten Pixel erhalten eine 1, die „Hintergrund“-Pixel eine 0. Das Schema der Einsen wird dann mit den Mustern in der OCR-Datenbank abgeglichen. Da dem Fleck unter dem „n“ des Johannes ebenfalls eine 1 zugeordnet wurde, entsprach das Schema eher dem Buchstaben und wurde als solcher umgesetzt.

Um Fehler zu vermeiden, können in einigen OCR- oder Scanprogrammen im Zuge des „Preprocessing“ diejenigen Bereiche des Dokumentes ausgewählt werden, die als Text erfasst werden sollen und die Abfolge der einzelnen Textfelder kann definiert werden (beispielsweise bei mehreren Spalten). Außerdem empfiehlt sich in diesem Schritt eine Optimierung der Farb- und Kontrastwerte (vgl. hierzu Kapitel 3 der DFG-Praxisregeln zur Digitalisierung).

6. Nachweise

- Berlin-Brandenburgischen Akademie der Wissenschaften, Berlin (Hrsg.) (2018): Deutsches Textarchiv. Grundlage für ein Referenzkorpus der neuhochdeutschen Sprache. http://www.deutschestextarchiv.de/.

- Deutsche Forschungsgemeinschaft (2016): DFG-Praxisregeln. „Digitalisierung“. URL: http://www.dfg.de/formulare/12_151/12_151_de.pdf [Zugriff: 22.1.2018].

- Eikvil, Line (1993): OCR. Optical Character Recognition. URL: https://www.nr.no/~eikvil/OCR.pdf [Zugriff: 22.1.2018].

- Geyken, Alexander, Mathhias Boenig, Susanne Haaf, Bryan Jurish, Christian Thomas und Frank Wiegand (2012): „TEI und Textkorpora: Fehlerklassifikation und Qualitätskontrolle vor, während und nach der Texterfassung im Deutschen Textarchiv“. In: Jahrbuch für Computerphilologie. Text abrufbar unter: http://www.computerphilologie.de/jg09/geykenetal.html (Zugriff am 22.1.2018).

- Grubmüller, Klaus und Klaus Weimar (1997): „Edition“. In: Reallexikon der deutschen Literaturwissenschaft. Neubearbeitung des Reallexikons der deutschen Literaturgeschichte, Berlin, New York: de Gruyter, 414-418.

- Haaf, Susanne, Frank Wiegand und Alexander Geyken (2013): „Measuring the Correctness of Double-Keying: Error Classification and Quality Control in a Large Corpus of TEI-Annotated Historical Text“. In: Journal of the Text Encoding Initiative. DOI: 10.4000/jtei.739.

- Kocher, Ursula (2007): „Textkritik“. In: Metzler Lexikon Literatur. Begriffe und Definitionen, Stuttgart, Weimar: Metzler, 761-762.

- Kraft, Herbert (2001): Editionsphilologie. Frankfurt am Main (u.a.): Lang.

- Nutt-Kofoth, Rüdiger (2007): „Textkritik und Textbearbeitung“. In: Thomas Anz (Hrsg.): Handbuch Literaturwissenschaft, Bd. 2: Methoden und Theorie. Stuttgart, Weimar: Metzler, 1–27.

- OCR-D. Koordinierungsprojekt zur Weiterentwicklung von Verfahren der Optical Character Recognition (OCR). http://ocr-d.de.

- Rehbein, Malte (2017): „Digitalisierung“. In: Fotis Jannidis; Hubertus Kohle und Malte Rehbein (Hrsg.): Digital Humanities. Eine Einführung. Stuttgart: Metzler, 179–198.

- Rohr, Christian (2015): Historische Hilfswissenschaften: eine Einführung. Wien (u.a.): Böhlau.

- Schneider, Karin (2003): „Paläographie“. In: Reallexikon der deutschen Literaturwissenschaft. Neubearbeitung des Reallexikons der deutschen Literaturgeschichte, Berlin, New York: de Gruyter, 1-3.

- Schneider, Karin (2014): Paläographie und Handschriftenkunde für Germanisten: eine Einführung. Berlin, New York: de Gruyter.

- Sproll, Monika (2007): „Editionstechnik“. In: Metzler Lexikon Literatur. Begriffe und Definitionen, Stuttgart, Weimar: Metzler, 178.

- Transkribus. Digitisation and Digital Preservation Group, Universität Innsbruck. https://transkribus.eu/Transkribus/. (vgl. → Transkribus)

7. Weiterführendes

- OCR-Bibliothek aus dem Projekt OCR-D: https://www.zotero.org/groups/418719/ocr-d

Die folgende Liste an Programmen, die Ihnen beim Scannen und bei der optischen Texterfassung (OCR) behilflich sein können, ist lediglich eine Auswahl an häufig genannten Tools und erhebt weder Anspruch auf Vollständigkeit noch auf Repräsentativität.

- Preprocessing-Programme

- ScanTailor (nicht für Mac): http://scantailor.org/

- ImageMagick: https://www.imagemagick.org/script/index.php

- Unpaper: https://github.com/Flameeyes/unpaper

- Leptonica: http://www.leptonica.com/

- OCR-Freeware

- OCR4all: https://lists.uni-wuerzburg.de/mailman/listinfo/ocr4all (vgl. → OCR4all)

- Tesseract: https://github.com/tesseract-ocr/tesseract

- OCRopus: https://github.com/tmbdev/ocropy

- PDF XChange View (nicht für Mac): https://www.tracker-software.com/product/pdf-xchange-viewer

- Google Docs: https://support.google.com/drive/answer/176692?hl=de&co=GENIE.Platform=D...

- Kostenpflichtige OCR-Software

- ABBYY FineReader: https://www.abbyy.com/de-de/finereader/ (vgl. → Abbyy FineReader)

- Adobe Reader Pro: https://acrobat.adobe.com/de/de/acrobat/acrobat-pro.html

- Omnipage: http://www.nuance.de/for-business/by-product/omnipage/index.htm