1. Definition

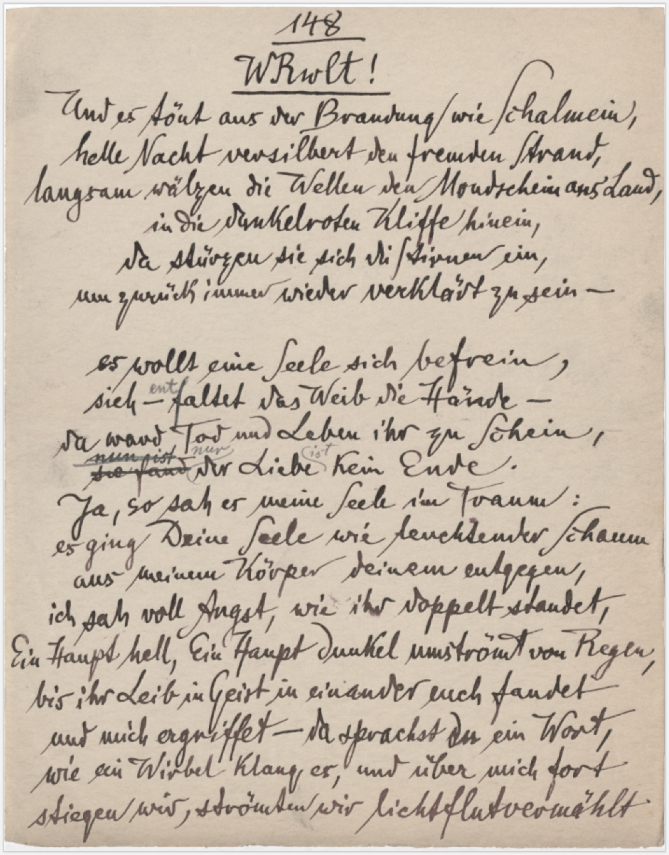

Die digitale Manuskriptanalyse beschäftigt sich mit der Auszeichnung bzw. Annotation kultureller Artefakte in Form eingescannter Handschriften. Sollten diese Bilddigitalisate aufgrund schlechter Lesbarkeit oder individueller und uneinheitlicher Handschrift nicht für eine automatisierte Texterfassung (vgl. → Möglichkeiten der Textdigitalisierung) in Frage kommen, werden die Manuskripte als Bilddateien gespeichert und als solche ausgezeichnet.

2. Anwendungsbeispiel

Haben Sie beispielsweise vor, ein Archiv von 50.000 Briefen Martin Bubers zu digitalisieren, könnten Sie nach dem Einscannen der Manuskripte (für das es unterstützende Workflows gibt, s. u.) entweder eine automatisierte Handschriftenerkennung anstreben, um den Inhalt der Texte digital analysierbar zu machen, oder die Briefscans in ihrem Zustand als Bilddateien belassen und als solche mit zusätzlichen Informationen (sog. Metadaten) bestücken. Die Briefe wären im Folgenden dann anhand dieser Metadaten analysierbar.

3. Literaturwissenschaftliche Tradition

Alle Textwissenschaften und Teilbereiche der Kulturwissenschaften beschäftigen sich mit dem Lesen, Annotieren, Analysieren oder Interpretieren von geschriebenen oder verschriftlichten Texten. Häufig werden dafür diese Texte übertragen (z. B. auf Papier) und nicht direkt auf dem Original bearbeitet – schon gar nicht, wenn es sich um historisch wertvolle Manuskripte handelt, die z. B. auf Pergament oder Papyrus verfasst sind, oder um Grabinschriften, Münzgravuren, etc. Während ein Manuskript als (autografes) Blatt vor allem Gegenstand materialwissenschaftlicher Betrachtungen wird, ist es als (allografe) Seite interessant für literaturwissenschaftliche Lektüren und Analysen (vgl. Benne 2015).

Bereits durch das Lesen eines Textes wird dieser funktional von seinem Trägermaterial unabhängig gemacht und dadurch immaterialisiert. Der Computer kann dies jedoch nicht implizit machen, sondern muss explizit lernen, wie dieser Schritt funktioniert (vgl. Rehbein 2017, 181). Der Text als immaterielle Größe ist deshalb in literaturwissenschaftlicher Hinsicht wie beim alltäglichen Lesen das Ziel der Digitalisierung. Dennoch vernachlässigen auch Literaturwissenschaftler*innen den autografen Aspekt nicht gänzlich, denn häufig können Informationen über die Schrift und das verwendete Material der literaturwissenschaftlichen Interpretation wesentliche Impulse geben. Nicht zuletzt für die Zitierbarkeit eines Textes ist die Angabe der jeweiligen Seite, auf der eine Textpassage zu finden ist, ein wichtiges Kriterium und sollte im Zuge der Umwandlung in einen elektronischen Text nicht verloren gehen.

Wie für die → Möglichkeiten der Textdigitalisierung allgemein lassen sich somit auch für die Manuskriptanalyse im Speziellen drei literaturwissenschaftliche Traditionslinien aufzeigen: (1) die Editionsphilologie und Textkritik, (2) die Paläografie und (3) das Setzen von Manuskripten seit der Erfindung des Buchdrucks.

4. Diskussion

Besonders in der Lehre bietet es sich an, nicht das Originalmanuskript, sondern ein Surrogat zu verwenden, um Zeit und Kosten zu sparen und um das Originalmanuskript zu schonen. Als Digitalisat lassen sich Manuskripte verlustfrei kopieren und vervielfältigen – ein Vorteil, den die klassische analoge Reproduktion nicht bietet (vgl. Rehbein 2017, 179). Die einzelnen Digitalisate können untereinander vernetzt und so in vielfältige Beziehungen zueinander gesetzt werden.

Ist ein Manuskript aufgrund seines Zustandes oder einer problematischen Handschrift nicht mit digitalen Methoden zu erfassen (d. h. vom Computer in einen elektronischen Text umzuwandeln), oder ist der Aufwand eines Keyings (d. h. des manuellen Transkribierens/Abtippens) im Rahmen des jeweiligen Projektes nicht zu rechtfertigen, können einige digitale Methoden die Arbeit mit den Texten zumindest unterstützen. In diesem Fall bleiben die eingescannten Manuskripte als Bilddateien gespeichert und werden als solche annotiert bzw. mit Metadaten versehen. Eine solche Operation lässt sich z. B. im Laboratory von → TextGrid ausführen.

Wenn Sie beispielsweise in den einzelnen Dokumenten der gesammelten Briefe der Familie Mann und etwaigen Gegenkorrespondenzen jeweils die Korrespondenzpartner oder auch die erwähnten Personen und Orte als Metadaten speichern, lässt sich die gesamte Textsammlung anhand dieser strukturellen Metadaten jeweils neu sortieren. Zudem kann eine Visualisierung als Netzwerk (→ Textvisualisierung, → Netzwerkanalyse) etwa Einblicke in die globale Vernetzung der Schriftstellerfamilie gewähren und somit wertvolle Beiträge zur Diskussion über Welt- oder europäische Literatur leisten.

Die Paläografie (die Lehre von alten Schriften) gilt derzeit als ein Arbeitsbereich für Experten. Die Zusammenarbeit mit Fachleuten aus dem Bereich der Computer Vision verspricht jedoch, im Zuge einer Automatisierung des Lesens von Handschriften zunehmend auch Nicht-Experten die textanalytische Arbeit mit Handschriften – deren Wert als Quellen des Wissens über die menschliche Kultur, Gesellschaft, Geschichte und nicht zuletzt regionale, nationale und übernationale Identität nicht genug betont werden kann – zu ermöglichen (vgl. Hassner et al. 2014).

Einen wichtigen Schritt in diese Richtung geht beispielsweise das EU-geförderte → Transkribus-Projekt. Gerade durch seine Aufspaltung in einen simple mode und einen expert mode und seine grafische Nutzeroberfläche ermöglicht es auch Einsteigern in der automatischen Handschriftenerfassung eine digitale Arbeit mit Manuskripten auf hohem Niveau. Entwicklungen im Bereich der automatischen Handschriftenerkennung werden beispielsweise diskutiert in Sanchez et al. (2014, 2015, 2016).

5. Technische Grundlagen

Haben Sie ein eingescanntes Manuskript als Datei vorliegen, testen Sie zunächst, ob es sich um eine Bilddatei oder ein computerlesbares Dokument handelt, indem Sie versuchen, einzelne Zeilen des Dokumentes zu markieren. Wird die gesamte Seite blau/ausgewählt, handelt es sich um eine Bilddatei (d. h. die Schrift ist für den Computer noch nicht lesbar); werden nur die von Ihnen markierten Zeilen blau bzw. ausgewählt, hat bereits eine OCR (optical character recognition) bzw. eine HTR (handwritten text recognition) stattgefunden (d. h. der Text des jeweiligen Dokumentes ist digitalisiert und als elektronischer Text vom Computer les- und analysierbar).

OCR und HTR sind sich sehr ähnlich, nur dass HTR nicht auf der Erkennung einzelner Buchstaben, sondern gesamter Wörter bzw. Zeilen basiert, da wir es bei Manuskripten in der Regel mit Schreibschriften zu tun haben, bei denen die einzelnen Buchstaben ineinander übergehen und je nach Vorgänger- oder Folgebuchstabe anders aussehen können.

Es gibt neben der OCR bzw. HTR etliche Möglichkeiten, Manuskripte in Digitalisierungsprojekten zu bearbeiten, wie z. B. eine forensische Dokumentanalyse, eine Quantifizierung schriftlicher „Fingerabdrücke“, metrische Analysen, der Einsatz von DNA-Analysemethoden oder Techniken multispektraler Bilddigitalisierung (vgl. Hassner et al. 2014, 18).

Im Zuge einer Bilddigitalisierung findet in technischer Hinsicht folgender Prozess statt: Aus dem analogen optischen Signal eines Manuskriptes wird zunächst eine Rastergrafik erstellt, die durch Bildgröße und Farbtiefe charakterisiert ist. Dafür wird jedem Punkt eines Bildes ein bestimmter Wert zugeordnet. Bei Schwarz-Weiß-Bildern ist das eine 0 für jeden weißen Punkt und eine 1 für jeden schwarzen Punkt. Schwarzweißbilder haben nur diese beiden Helligkeitswerte, komplizierter wird es bei Graustufen- oder gar Farbdigitalisaten. Bei Graustufen wird der Farbkanal schwarz/weiß genauer ausdifferenziert, bei farbigen Scans kommen mehrere Farbkanäle hinzu wie z. B. Rot, Grün und Blau im weit verbreiteten RGB-Modell, deren Kombinationen eine riesige Palette an Mischfarben erzeugen können (vgl. Rehbein 2017, 182).

Ob die korrekte Wiedergabe von Farben im Digitalisat wichtig ist, ist projektspezifisch. Geht es ausschließlich darum, den Text eines Manuskriptes computerlesbar zu machen, unabhängig davon, ob einige Passagen beispielsweise in einer anderen Farbe geschrieben sind, reicht eine Schwarz-Weiß-Digitalisierung völlig aus und spart zudem Speicherplatz. Denn je nach Menge und (Farb-)Qualität der Digitalisate, die Sie für Ihr Projekt erstellen wollen, können schnell große Datenmengen entstehen. Die DFG (2013, 6) empfiehlt daher in ihren Praxisregeln Digitalisierung für eine Bildkompression das Speicherformat TIFF, das bei Bedarf eine verlustfreie Reproduktion des ursprünglichen unkomprimierten Scans ermöglicht, wodurch eine Nachhaltigkeit und Langzeitarchivierung sichergestellt ist.

Die Qualität des Digitalisats ist entscheidend für die weitere wissenschaftliche Bearbeitung. So kann eine bestimmte Stelle im Manuskript tatsächlich unlesbar sein, oder sie ist die Folge einer zu geringen Auflösung oder Farbtiefe des Digitalisats. Soll das Digitalisat mit dem bloßen Auge gut lesbar sein, empfiehlt sich eine Mindestauflösung von 300ppi (pixel per inch). Ist das Ziel jedoch eine Computerlesbarkeit der Handschrift, werden von der digitalen Paläografie deutlich höhere Auflösungen gefordert, damit z. B. detailliertere Analyseverfahren der Computer Vision angewandt werden können (vgl. Hassner et al. 2014, 20f.).

Um ideale Bedingungen für einen Scanvorgang zu schaffen, hat das Transkribus-Projekt das sog. ScanTent entwickelt, das den Scanprozess beschleunigt und die jeweilige Manuskriptseite perfekt ausleuchtet. Dadurch werden Fehler, die einer mangelhaften Digitalisierung zuschulden kommen können, minimiert. Die mit Hilfe des ScanTents und der mobilen Scan-App DocScan (für Android) erzeugten PDF-Dokumente können über die App direkt auf einen Transkribus-Account hochgeladen werden (vgl. das umfangreiche Transkribus-Wiki für weitere Informationen und Anleitungen).

Es ist möglich, individuelle Handschriften zu „trainieren“, d. h. dem Computer durch manuelle Transkription ausgewählter Manuskripte zu ermöglichen, weitere Manuskripte des gleichen Autors (bzw. des gleichen Schriftstils) automatisch erkennen bzw. „lesen“ zu können. Die Erkennung funktioniert besser, je umfangreicher dieses Modell zuvor trainiert wurde. In einem Transkriptionsprojekt für venezianische Handschriften des 18. Jahrhunderts wurde beispielsweise ein Modell trainiert, das weitere Manuskripte der Sammlung mit einer geringeren Fehlerrate transkribiert als Amateur-Transkribierende das zu leisten vermochten (vgl. Oliveira und Kaplan 2018). Das langfristige Ziel von HTR-Initiativen ist es, so viele unterschiedliche Schreibstile zu trainieren, dass es zukünftig möglich sein wird, die meisten handschriftlichen Dokumente ohne vorheriges individuelles Training zu erkennen – ähnlich wie es auch schon im OCR-Verfahren für die meisten Druckschriften funktioniert.

Da die Handschriftenerkennung nicht auf Grundlage einzelner Buchstaben, sondern ganzer Zeilen funktioniert, müssen (im Gegensatz zum OCR) bei einem HTR-Vorgang die Zeilen (und ihre Reihenfolge, was z. B. bei mehrspaltigen Texten oder Ergänzungen zwischen den einzelnen Zeilen sehr relevant wird) zunächst festgelegt werden. Transkribus bietet hier beispielsweise eine automatisierte Zeilenerkennung, die händisch manipuliert werden kann.

Sollte es nicht das Ziel Ihres Projektes sein, die Manuskripte in einen elektronisch lesbaren Text umzuwandeln, können die Scans auch lediglich als Bilddateien verarbeitet werden. Neben den strukturellen Metadaten, die Informationen über die inhaltliche Struktur eines digitalisierten Objektes verzeichnen, gibt es deskriptive, technische oder administrative Metadaten. Als deskriptive Metadaten lassen sich beispielsweise Informationen über Epochen- oder Textsortenzugehörigkeit oder Informationen über den Autor eines Manuskriptes speichern. Technische Metadaten verzeichnen den Zustand des digitalisierten Objektes (wie etwa seine Auflösung) und administrative Metadaten beispielsweise Zugriffsrechte unterschiedlicher Personengruppen (vgl. Rehbein 2017, 192). Metadaten werden meistens im XML-Dateiformat gespeichert. Informationen und Guidelines zur Erstellung von Metadaten bietet beispielsweise die Text Encoding Initiative (TEI).

6. Nachweise

- Benne, Christian (2015): Die Erfindung des Manuskripts. Zur Theorie und Geschichte literarischer Gegenständlichkeit. Berlin: Suhrkamp.

- Deutsche Forschungsgemeinschaft (2016): DFG-Praxisregeln. „Digitalisierung“. URL: http://www.dfg.de/formulare/12_151/12_151_de.pdf [Zugriff: 12.7.2018].

- Hassner, Tal, Malte Rehbein, Peter A. Stokes und Lior Wolf (2014): „Computation and Paleography: Potentials and Limits“. In: Dagstuhl Manifesto. 2 (1), 14–35.

- Oliveira, Sofia Ares und Frederic Kaplan (2018): „Comparing human and machine performancesiIn transcribing 18th century handwritten Venetian script“. In: DH 2018. Conference Abstracts, URL: https://dh2018.adho.org/en/comparing-human-and-machine-performances-in-transcribing-18th-century-handwritten-venetian-script/ [Zugriff: 11.7.2018].

- Rehbein, Malte (2017): „Digitalisierung“. In: Fotis Jannidis; Hubertus Kohle und Malte Rehbein (Hrsg.): Digital Humanities. Eine Einführung. Stuttgart: Metzler, 179–198.

- Sánchez, Joan Andreu, Verónica Romero, Alejandro H. Toselli und Enrique Vidal (2014): ICFHR2014 Competition on Handwritten Text Recognition on tranScriptorium Datasets (HTRtS). 181–186.

- Sánchez, Joan Andreu, Alejandro H. Toselli, Verónica Romero und Enrique Vidal (2015): ICDAR 2015 competition HTRtS: Handwritten Text Recognition on the tranScriptorium Dataset. Tunis, 1166–1170.

- Sánchez, Joan Andreu, Verónica Romero, Alejandro H. Toselli und Enrique Vidal (2016): ICFHR2016 Competition on Handwritten Text Recognition on the Read Dataset. 630–635.

- TEI: Text Encoding Initiative. http://www.tei-c.org/index.xml [Zugriff: 11. Juli 2018].

- Transkribus. Digitisation and Digital Preservation Group, Universität Innsbruck. https://transkribus.eu/Transkribus/ [Zugriff: 11. Juli 2018].